CLIP神经网络可以有效地从自然语言监督中学习视觉。只需提供要识别的视觉类别的名称,CLIP 就可以应用于任何视觉分类基准,类似于 GPT-2 和 GPT-3 的“零样本”功能。

尽管深度学习彻底改变了计算机视觉,但当前的方法仍存在几个主要问题:

1:典型的视觉数据集需要大量劳动力,创建成本高昂,同时只能教授一组狭窄的视觉概念;2:标准视觉模型只擅长一项任务,需要付出巨大努力才能适应新任务;3:在基准测试中表现良好的模型在压力测试中表现却令人失望,这使人们对整个计算机视觉深度学习 方法产生了怀疑。

我们提出了一个旨在解决这些问题的神经网络:它使用各种各样的图像进行训练,并使用互联网上大量可用的各种自然语言监督。根据设计,可以用自然语言指示网络执行各种各样的分类基准测试,而无需直接优化基准测试的性能,类似于“零样本”(在新窗口中打开)” GPT-2 5 和 GPT-3 的功能。这是一个关键的变化:通过不直接针对基准进行优化,我们表明它变得更具代表性:我们的系统将这种“鲁棒性差距”缩小了 75%,同时 在 ImageNet上与原始 ResNet-50的性能相匹配(在新窗口中打开) 零样本测试,不使用任何原始的 1.28M 个标记示例。

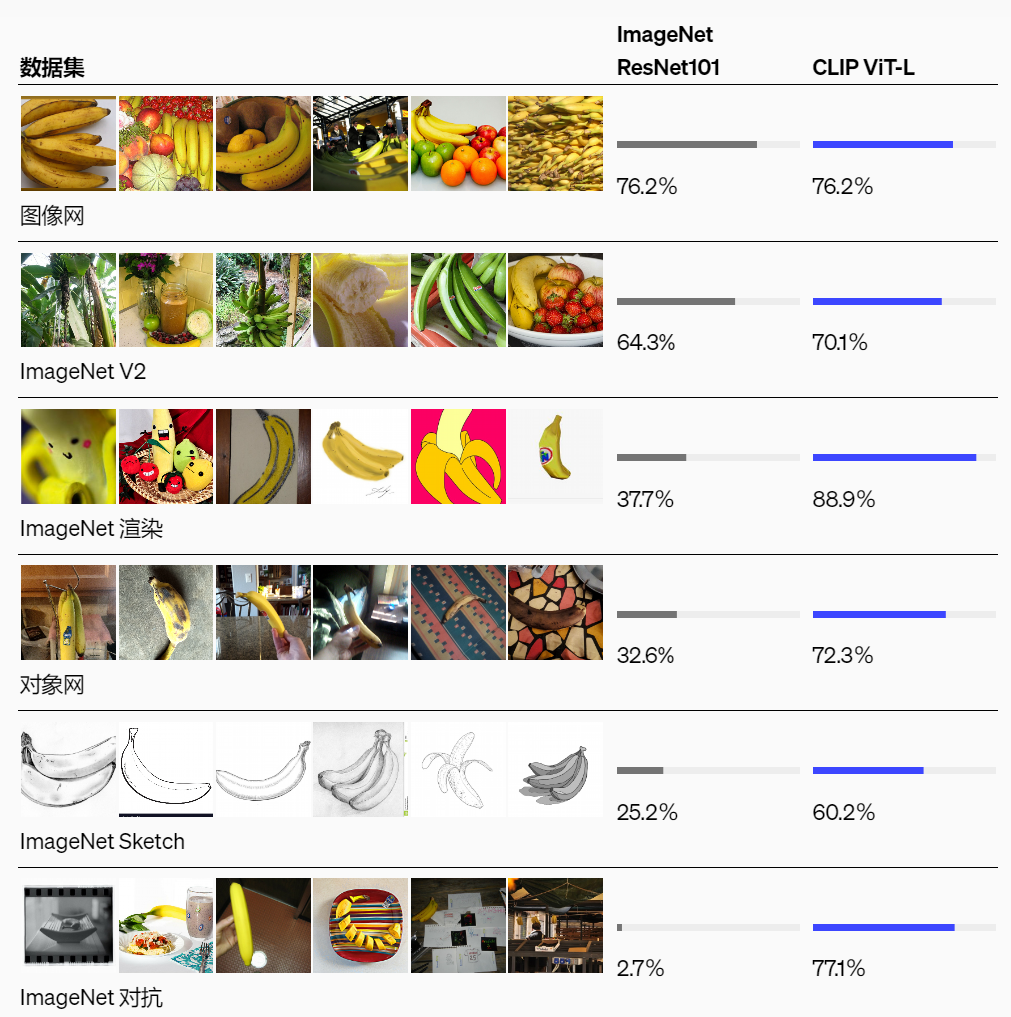

lCLIP比ImageNet普遍适应性更强:

尽管两种模型在 ImageNet 测试集上的准确率相同,但 CLIP 的表现更能体现其在不同非 ImageNet 设置中衡量准确率的数据集上的表现。例如,ObjectNet 检查模型识别家中不同姿势和不同背景下的物体的能力,而 ImageNet Rendition 和 ImageNet Sketch 检查模型识别物体更抽象描述的能力。

CLIP(对比语言-图像预训练)建立在零样本迁移、自然语言监督和多模态学习方面的大量工作之上。零数据学习的想法可以追溯到十多年前,但直到最近,它主要在计算机视觉领域被研究作为一种推广到看不见的物体类别的方式。一个关键的见解是利用自然语言作为灵活的预测空间来实现泛化和迁移。2013 年,斯坦福大学的 Richer Socher 和合著者通过在 CIFAR- 10 上训练模型来在词向量嵌入空间中进行预测,开发了一个概念证明,并表明该模型可以预测两个看不见的类别。同年,DeVISE扩展了这种方法,并证明可以对 ImageNet 模型进行微调,使其可以推广到正确预测原始 1000 个训练集之外的物体。

对 CLIP最有启发意义的是 Ang Li 及其合著者在 FAIR上所做的工作 ,他们在 2016 年展示了如何使用自然语言监督实现对多个现有计算机视觉分类数据集(例如经典 ImageNet 数据集)的零样本迁移。他们通过微调 ImageNet CNN 来实现这一点,该 CNN 从 3000 万张 Flickr 照片的标题、描述和标签文本中预测更广泛的视觉概念(视觉 n-gram)。

最后,CLIP 是过去一年中重新审视从自然语言监督中学习视觉表征的一组论文的一部分。这一系列工作使用了更现代的架构,例如 Transformer ,其中包括探索自回归语言建模的 VirTex 、研究掩码语言建模的 ICMLM和研究我们用于 CLIP 的相同对比目标的 ConVIRT,但在医学成像领域。

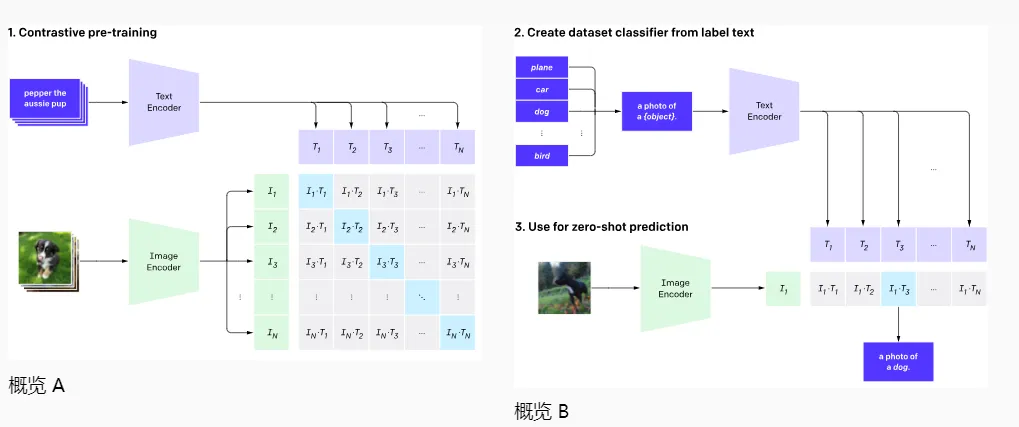

我们表明,扩展一个简单的预训练任务就足以在各种图像分类数据集上实现具有竞争力的零样本性能。我们的方法使用大量可用的监督源:在互联网上找到的与图像配对的文本。此数据用于为 CLIP 创建以下代理训练任务:给定一张图像,预测在我们的数据集中,一组 32,768 个随机采样的文本片段中哪一个实际上与其配对。

为了解决这一任务,我们的直觉是 CLIP 模型需要学习识别图像中的各种视觉概念并将它们与名称联系起来。因此,CLIP 模型可以应用于几乎任意的视觉分类任务。例如,如果数据集的任务是对狗和猫的照片进行分类,我们会针对每张图像检查 CLIP 模型预测文本描述“狗的照片 ”或“猫的照片 ”是否更有可能与其配对。

CLIP 预先训练了一个图像编码器和一个文本编码器,以预测哪些图像与数据集中的哪些文本配对。然后,我们利用这种行为将 CLIP 转变为零样本分类器。我们将数据集的所有类别转换为标题,例如“一张狗的照片”,并预测 CLIP 估计的与给定图像最 佳配对的标题类别。

lCLIP 的设计目的在于缓解标准深度学习计算机视觉方法中的一些主要问题:

昂贵的数据集:深度学习需要大量数据,而视觉模型传统上是在手动标记的数据集上进行训练的,这些数据集构建成本高昂,并且仅对有限数量的预定视觉概念提供监督。ImageNet 数据集是该领域最 大的努力之一,需要超过 25,000 名工作人员为 22,000 个对象类别注释 1400 万张图像。

相比之下,CLIP 从互联网上已经公开的文本-图像对中进行学习。减少对昂贵的大型标记数据集的需求已在先前的工作中得到广泛研究,特别是自监督学习、 对比方法、自训练 方法、和生成模型。

狭义:ImageNet 模型擅长预测 1000 个 ImageNet 类别,但这就是它“开箱即用”的全部功能。如果我们想执行任何其他任务,ML 从业者需要构建新的数据集、添加输出并微调模型。

相比之下,CLIP 可以适应执行各种各样的视觉分类任务,而无需额外的训练示例。要将 CLIP 应用于新任务,我们需要做的就是“告诉”CLIP 的文本编码器任务的视觉概念的名称,它就会输出 CLIP 视觉表示的线性分类器。这种分类器的准确性通常与全监督模型相媲美。

现实世界表现不佳:深度学习系统在视觉基准测试中的表现通常与人类相当,甚至超过人类,但在实际部署时,它们的表现可能远低于基准测试设定的期望。换句话说,“基准测试表现”和“实际表现”之间存在差距。

我们推测,这种差距的出现是因为模型“作弊”只针对基准测试表现进行优化,就像学生只通过学习往年考试的问题就通过了考试。相比之下,CLIP 模型可以在基准测试中进行评估,而无需在其数据上进行训练,因此它不能以这种方式“作弊”。这使得它的基准测试表现更能代表其在实际环境中的表现。

为了验证“作弊假设”,我们还测量了 CLIP 在能够“学习”ImageNet 时的性能变化。当在 CLIP 的特征上安装线性分类器时,它将 CLIP 在 ImageNet 测试集上的准确率提高了近 10%。然而, 在衡量“稳健”性能的其他 7 个数据集的评估套件中,该分类器的平均表现并不 更好.

lCLIP核心关键要点

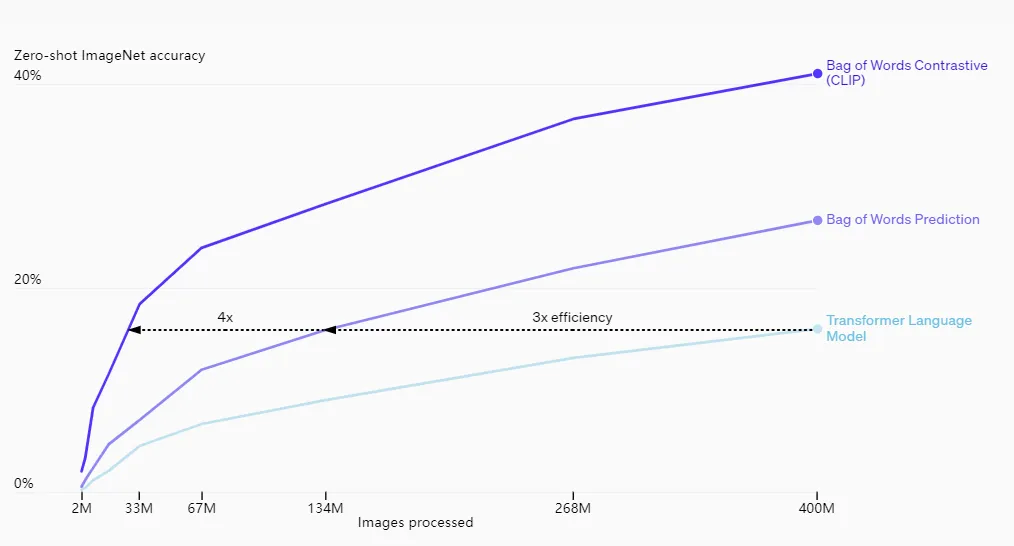

1. CLIP 效率高

CLIP 从未过滤、高度多样化且噪声很大的数据中学习,旨在以零样本方式使用。我们从 GPT-2 和 3 中了解到,在此类数据上训练的模型可以实现令人信服的零样本性能;然而,这样的模型需要大量的训练计算。为了减少所需的计算,我们专注于提高我们方法的训练效率的算法方法。

我们报告了两种可显著节省计算资源的算法选择。第 一种选择是采用对比目标将文本与图像连接起来。我们 最初探索了一种类似于 VirTex 的图像到文本方法,但在扩展该方法 以实现最 佳性能方面遇到了困难。在中小规模的实验中,我们发现 CLIP 使用的对比目标在零样本 ImageNet 分类中的效率提高了 4 到 10 倍。第二种选择是采用 Vision Transformer与标准 ResNet 相比,这使我们的计算效率提高了 3倍。最后,我们表现最 好的 CLIP 模型在 256 个 GPU 上训练了 2周, 这与现有的大规模图像模型类似。

我们最初探索了训练图像到字幕的语言模型,但发现这种方法在零样本迁移方面遇到了困难。在这个为期 16 天的 GPU 实验中,语言模型在训练了 4 亿张图像后,在 ImageNet 上仅实现了 16% 的准确率。CLIP 效率更高,实现相同准确率的速度大约快 10 倍。

2. CLIP 灵活、通用

由于 CLIP 模型直接从自然语言中学习广泛的视觉概念,因此它们比现有的 ImageNet 模型更加灵活和通用。我们发现它们能够零样本执行许多不同的任务。为了验证这一点,我们在 30 多个不同的数据集上测量了 CLIP 的零样本性能,包括细粒度对象分类、地理定位、视频中的动作识别和 OCR 等任务。特别是,学习 OCR 是一个令人兴奋的行为的例子,它不会发生在标准的 ImageNet 模型中。上面,我们可视化了每个零样本分类器的随机非精选预测。

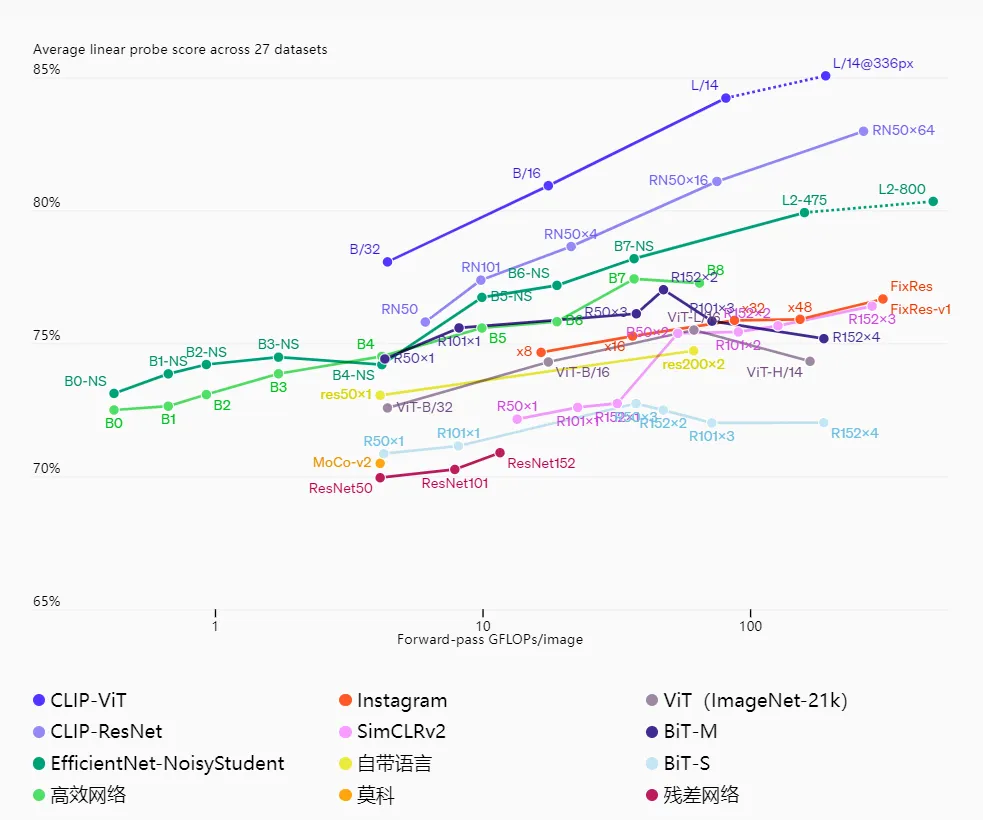

这一发现也反映在使用线性探针的标准表征学习评估中。最 佳 CLIP 模型在我们测试的 26 个不同的传输数据集中的 20 个上表现优于最 佳公开可用的 ImageNet 模型 Noisy Student EfficientNet-L2,达到23 分 。

在 27 个数据集中,我们发现 CLIP 模型可以学习更广泛有用的图像表示,这些数据集用于测量细粒度对象分类、OCR、视频中的活动识别和地理定位等任务。CLIP 模型的计算效率也高于我们之前比较的 10 种方法中的模型。

虽然 CLIP 通常能很好地识别常见物体,但它在更抽象或系统的任务(例如计算图像中的物体数量)和更复杂的任务(例如预测照片中最近的汽车有多近)上表现不佳。在这两个数据集上,零样本 CLIP 仅比随机猜测略胜一筹。与特定任务模型相比,零样本 CLIP 在非常细粒度的分类上也表现不佳,例如区分汽车型号、飞机变体或花卉种类。

CLIP 对其预训练数据集中未涵盖的图像的泛化能力仍然较差。例如,尽管 CLIP 学习了一个功能强大的 OCR 系统,但在对 MNIST 数据集中的手写数字进行评估时,零样本 CLIP 的准确率仅为 88%,远低于人类在该数据集上的 99.75%。最后,我们观察到 CLIP 的零样本分类器可能对措辞或短语很敏感,有时需要反复试验的“快速工程”才能取得良好效果。

CLIP 允许人们设计自己的分类器,并且无需针对特定任务进行训练数据。这些类别的设计方式会严重影响模型性能和模型偏差。例如,我们发现,当给定一组标签(包括 Fairface种族标签C和一些恶劣术语,例如“罪犯”、“动物”等)时,该模型倾向于将 0-20 岁人群的图像归类为恶劣类别,比率约为 32.3%。但是,当我们将“儿童”类别添加到可能的类别列表中时,这种行为会下降到约 8.7%。

此外,鉴于 CLIP 不需要特定于任务的训练数据,它可以更轻松地解锁某些小众任务。其中一些任务可能会引发隐私或监视相关的风险,我们通过研究 CLIP 在名人识别方面的表现来探讨这一问题。在从 100 个候选对象中进行选择时,CLIP 对“自然”名人图像分类的 top-1 准确率为 59.2%,在从 1000 个可能的选择中进行选择时,top-1 准确率为 43.3%。虽然使用与任务无关的预训练实现这些结果值得注意,但与广泛可用的生产级模型相比,这种性能并不具有竞争力。我们将在论文中进一步探讨 CLIP 带来的 挑战(在新窗口中打开) 我们希望这项工作能够激发未来对此类模型的能力、缺点和偏差进行表征的研究。我们很高兴能与研究界就这些问题展开合作。

利用 CLIP,我们测试了在互联网规模的自然语言上进行任务无关预训练(这推动了 NLP 领域近期的突破)是否也能用于提高其他领域的深度学习性能。到目前为止,将这种方法应用于计算机视觉所取得的成果让我们感到兴奋。与 GPT 系列一样,CLIP 在预训练期间学习了各种各样的任务,我们通过零样本迁移进行了演示。我们在 ImageNet 上的发现也让我们备受鼓舞,表明零样本评估是衡量模型能力的更具代表性的指标。

公众号 扫码咨询

|

上海市闵行区中春路4999号莘庄商务楼1326室 |

|

service@covond.com |

|

www.covond.com |

|

交换机:18017588179(孙经理) 无人机:13311882358(孙总) |